Forschungsseminar

Das Forschungsseminar richtet sich an interessierte Studierende des Master- oder Bachelorstudiums. Andere Interessenten sind jedoch jederzeit herzlich willkommen! Die vortragenden Studenten und Mitarbeiter der Professur KI stellen aktuelle forschungsorientierte Themen vor. Vorträge werden in der Regel in Englisch gehalten. Den genauen Termin einzelner Veranstaltungen entnehmen Sie bitte den Ankündigungen auf dieser Seite.

Informationen für Bachelor- und Masterstudenten

Die im Studium enthaltenen Seminarvorträge (das "Hauptseminar" im Studiengang Bachelor-IF/AIF bzw. das "Forschungsseminar" im Master) können im Rahmen dieser Veranstaltung durchgeführt werden. Beide Lehrveranstaltungen (Bachelor-Hauptseminar und Master-Forschungsseminar) haben das Ziel, dass die Teilnehmer selbstständig forschungsrelevantes Wissen erarbeiten und es anschließend im Rahmen eines Vortrages präsentieren. Von den Kandidaten wird ausreichendes Hintergrundwissen erwartet, das in der Regel durch die Teilnahme an den Vorlesungen Neurocomputing (ehem. Maschinelles Lernen) oder Neurokognition (I+II) erworben wird. Die Forschungsthemen stammen typischerweise aus den Bereichen Künstliche Intelligenz, Neurocomputing, Deep Reinforcement Learning, Neurokognition, Neurorobotische und intelligente Agenten in der virtuellen Realität. Andere Themenvorschläge sind aber ebenso herzlich willkommen!Das Seminar wird nach individueller Absprache durchgeführt. Interessierte Studenten können unverbindlich Prof. Hamker kontaktieren, wenn sie ein Interesse haben, bei uns eine der beiden Seminarveranstaltungen abzulegen.

Kommende Veranstaltungen

Parameter-Efficient Fine-tuning of LLMs for Domain-Specific Programming LanguagesSupriya Dravid Tue, 3. 6. 2025, 14:00, https://webroom.hrz.tu-chemnitz.de/gl/mic-cv7-ptw This thesis investigated how Large Language Models (LLMs) could be adapted to generate reliable code for domain-specific languages, with a focus on ABAP, the core programming language used in SAP systems. Unlike widely used general-purpose languages, domain-specific languages like ABAP are significantly underrepresented in public datasets. This lack of representation poses a challenge, as zero-shot code generation often results in outputs that are inaccurate, incomplete, or misaligned with enterprise coding standards. To address this issue, the study explored parameter-efficient fine-tuning techniques, LoRA (Low-Rank Adaptation) and QLoRA (Quantized LoRA). These methods selectively fine-tuned small subsets of parameters while keeping the original pretrained model weights mostly unchanged. This approach enabled effective domain adaptation with much lower computational and memory overhead compared to full-model retraining. The methods were applied to small and mid-sized open-source models such as Phi-3-mini and Codegen-2B, and their performance was evaluated using metrics including Pass@k, CodeBLEU, and perplexity. In addition to this, the research included qualitative assessments from experienced ABAP developers, who rated the generated code based on functional correctness, performance, robustness, and maintainability. The results demonstrated that fine-tuned models significantly outperformed zero-shot baselines across all evaluation criteria. This work provides practical insights into how LLMs could be adapted for specialized programming environments, offering a cost-effective pathway for integrating generative AI into enterprise software development workflows. |

Biologisch Inspierierte Active VisionJan Chevalier Mon, 15. 5. 2034, 10:00, 1/336 and https://webroom.hrz.tu-chemnitz.de/gl/mic-cv7-ptw Das aktive Sehen bei Robotern kann durch biologisch inspirierte Ansätze gelöst werden. Es werden 2 verschiedene Ansätze für das selbständige Zurechtfinden eines Roboters vorgestellt. Einmal ein Modell, welches sich selbst ein internes Modell der Umwelt macht ("A Hierarchical System for a Distributed Representation of the Peripersonal Space of a Humanoid Robot", M. Antonelli, 2014). Außerdem ein Modell, welches an 3 verschieden Roboterköpfen getestet wurde ("A Portable Bio-Inspired Architecture for Efficient Robotic Vergence Control", A. Gibaldi, 2017). Des Weiteren wird ein Ansatz der biologisch inspirierten Objekterkennung vorgestellt ("Active Vision : on the relevance of a Bio-inspired approach for object detection", K. Hoang, 2019). |

Vergangene Veranstaltungen

Developing a Topology Optimization Tool for Human Experts - Implementing Machine Learning Approaches into the Hybrid Cellular Automata MethodChristoph Ruff Thu, 17. 4. 2025, 1/336 and https://webroom.hrz.tu-chemnitz.de/gl/mic-cv7-ptw Due to the large nonlinearities that occur in crash simulations, topology optimization of crashworthiness structures poses a challenging field. To date, the global minima and, consequently, the optimal design of crashworthiness structures remain often unknown. Therefore, specialized methods, such as the Hybrid Cellular Automata (HCA) method, have been implemented. The HCA method is a heuristic-based method with the goal to homogenize the Internal Energy Density (IED) of the design. While this approach is suitable for certain crashworthiness structures, it has several limitations that make this method unsuitable for the use in an industrial context. Therefore, in this work, the HCA method has been adapted using Machine Learning (ML) algorithms to address these challenges. K-Means clustering was employed to reduce the design variables and enhance the interpretability and manufacturability of the optimized design. eXplainable Artificial Intelligence (XAI) methods were then applied to obtain the importance of each feature for each cluster. Furthermore, dimensionality reduction algorithms, namely Principal Component Analysis (PCA) and AutoEncoder (AE), were implemented to extract and utilize additional information from the crash analysis. This information was combined into a single feature, which was subsequently homogenized instead of the IED. The developed algorithms were investigated using an application example. While no method has surpassed the results of the state-of-the-art HCA method, numerous promising approaches have been proposed and were analyzed. A proof-of-concept has been demonstrated for the combined feature homogenization, whereas further research is needed to achieve good results for the reduction of design variables. Nonetheless, this thesis presents valuable results that can serve as a foundation for future research. |

Modellierung von dynamischer Aufmerksamkeitsmodulation in der visuellen SucheIna Lin Thu, 27. 3. 2025, 1/367 and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz Um ein gesuchtes Objekt in einer Umgebung ausfindig zu machen, wird eine interne Repräsentation der Merkmale des Objekts gebildet. Diese interne Repräsentation, auch Attention Template genannt (Duncan & Humphreys, 1989; Witkowski & Geng, 2019), erhöht durch die neuronale Gain-Modulation die Aktivität der relevanten, merkmalspezifischen Neuronen des gesuchten Objekts (Maunsell & Treue, 2006; Reynolds & Heeger, 2009; Treue & Trujillo, 1999). Merkmale wie zum Beispiel Farbtöne, Orientierung etc. werden in der Suche zwischen relevanten Reizen (Targets) und irrelevanten Reizen (Nontargets) unterschieden. Die Differenz des neuronalen Hervorhebens zwischen den beiden Reizarten, das Signal-Rausch-Verhältnis (SNR), ermöglicht eine effiziente Auswahl eines Objekts (Peltier & Becker, 2016). Die optimale Aufmerksamkeitsmodulation (optimal tuning) bezieht sich auf die Steuerung der Suche durch Neuronen, die Merkmale kodieren, welche sich vom Distraktor unterscheiden. Nach den Erkenntnissen von Maith et al. (2021), dass sich das Attention Template durch Lernprozesse in den Basalganglien bildet, wird in der Neurocomputing- Studie ?How the Basal Ganglia Could Contribute to Optimal Tuning of the Attentional Template?, ein Modell aus dem visuellen System und den Basalganglien zusammengeführt, um diesen Ansatz auf das Cueing-Paradigma von Kerzel (2020) zu erweitern. Das Modell ist in der Lage, ein farbiges Target unter Distraktoren durch Aufmerksamkeitsmodulation ausfindig zu machen. Allerdings zeigen Kerzel und Cong (2021), dass die Form des Attention Templates von der Art der Suchaufgabe abhängt: Bei Singleton Search (SiS) (farbiges Target, einfarbige oder nicht farbige Nontargets) ist die Aufmerksamkeitskarte eher breit gefächert, während bei Feature Search (FeS) (farbiges Target, farbig variierende Nontargets) das Attention Template schmaler ist. In FeS müssen aktiv mehr nichtrelevante Merkmale der Nontargets unterdrückt werden, was zu einer verstärkten Aktivierung des indirekten Pfades führt, während bei SiS weniger Unterdrückung erforderlich ist. Dadurch ist die Aktivierung des indirekten Pfades bei SiS geringer. Zudem kann eine Wiederholung der gleichen Target-Nontarget-Beziehung das Attention Template beeinflussen (Kerzel & Huynh Cong, 2024). |

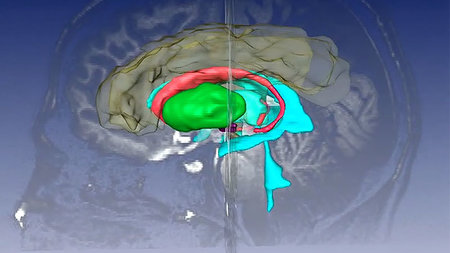

Replicating physiological data with a new basal ganglia - prefrontal cortex modelSusanne Holtzsch Wed, 26. 3. 2025, 1/367 and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz The basal ganglia play a fundamental role in category learning and action selection. They learn in a supervised way, with their connections rapidly adapting based on a reward prediction error regulated by dopamine levels. By learning stimulus-response associations, they teach the cortico-cortical connection from the inferior temporal cortex (IT) to the prefrontal cortex (PFC), so that the PFC acquires stable, abstract category knowledge. In the published model (Villagrasa, 2018), this dynamic was simulated when the model performed a Prototype Distortion Task (PDT). In this task, previously done with macaque monkeys, the goal is to classify visual dot stimuli of two categories. The model was able to replicate the development of category selectivity recorded in the monkeys' PFC. However in an online learning task, catastrophic forgetting occurred. So the model was updated by including inhibitory interneurons to make the PFC more sparse. Additionally a certainty signal was added which controls, that when the model classifies a stimulus with high confidence, the PFC directly determines the response. The thesis investigates whether the updated model can still replicate the physiological data and perform well in the PDT, as well as how increased sparsity affects PFC category selectivity. Furthermore, it explores whether specific model parameters or adjustments can help the new model replicate behavioral data more accurately. |

Predictive Coding LightJochen Triesch Thu, 13. 3. 2025, 1/336 Current machine learning systems consume vastly more energy than biological brains. Neuromorphic systems aim to overcome this difference by mimicking the brain?s information coding via discrete voltage spikes. However, it remains unclear how both artificial and natural networks of spiking neurons can learn energy-efficient information processing strategies. Here we propose Predictive Coding Light (PCL), a recurrent hierarchical spiking neural network for unsupervised representation learning. In contrast to previous predictive coding approaches, PCL does not transmit prediction errors to higher processing stages. Instead it suppresses the most predictable spikes and transmits a compressed representation of the input. Using only biologically plausible spike-timing based learning rules, PCL reproduces a wealth of findings on information processing in visual cortex and permits strong performance in downstream classification tasks. Overall, PCL offers a new approach to predictive coding and its implementation in natural and artificial spiking neural networks. |

ANNarchy 5.0Julien Vitay and a special guest Wed, 5. 3. 2025, 1/367a and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz We will present the novel (optional) interface of the neuro-simulator ANNarchy (Artificial Neural Networks architect) introduced in the release 5.0.0. In addition to a simpler definition of neurons and synapses, the new Network interface allows to completely separate networks from each other and run them sequentially or in parallel. |

Implicit Neural Representations for Spatio-Temporal Modeling of Satellite-Derived Surface ReflectanceVladyslav Shapran Mon, 17. 2. 2025, https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz Implicit Neural Representations (INRs) have demonstrated tremendous success in solving various inverse problems, spearheaded by Neural Radiance Fields (NeRFs) in the field of 3D scene reconstruction. Recently INRs have also found applications in Satellite Remote Sensing, where the research has been mostly focused on satellite photogrammetry with the goal to recover the true surface reflectance of the scene instead of radiance. These works have mostly focused on modeling of shadows, illumination, and on accounting for other environmental effects; however, they have given little attention to the INR model itself, and how the inductive biases of its architecture regularize the reconstructed scene. In addition, the adoption of INRs has been rather slow for more conventional satellite remote sensing applications other then photogrammetry, which are mostly focused on two-dimensional data and on spatio-temporal modeling. In this work we attempt to bridge this gap by studying how INRs can be used to model the surface reflectance in two-dimensional case, using atmosphere-corrected reflectance images from the Sentinel-2 satellite, as well as an additional synthetic data set that we create. Most importantly, we decide to forego the modeling of environmental effects and instead study the differences between various INR architectures and how suitable they are for reconstructing geospatial data. We further extend our research to the spatio-temporal case by studying how a trained INR model generalizes to different time-steps of the same scene. To this end, we run an extensive hyperparameter optimization for NeRF, Fourier-NeRF, SIREN, Gaussian-based INR, and wavelet-based WIRE architectures. We further propose to slightly modify the WIRE architecture by adding a sigmoid activation right before the last layer. This new architecture, which we call S-WIRE, produces impressive reconstructions of surface reflectance scenes, which far surpass all other models that we test. Most spectacularly, S-WIRE can almost perfectly reconstruct a previously unseen time-step of the training scene using only a few sample measurements. We hope that our work can facilitate the use of INRs for other remote sensing tasks in general, and for spatial or spatio-temporal geospatial data in particular. |

Time-Dynamic Cherry Blossom Prediction Using FORCE-Trained Echo State NetworksGantogoo Oyunbat Thu, 13. 2. 2025, 1/346 and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz The human brain performs complex predictive tasks while consuming minimal energy, highlighting the vast efficiency gap between biological and artificial computing systems. While modern computers offer impressive computational capabilities, their energy requirements limit widespread deployment of predictive models. Neural systems inspire reservoir computing approaches that aim to bridge this gap, combining computational power with energy efficiency. In this study, we explore this potential by applying reservoir computing to a real-world time-dynamic forecasting challenge: cherry blossom date prediction, a task of cultural, ecological, and economic importance in Japan. This study uses an Echo State Network (ESN) with FORCE (First-Order Reduced and Controlled Error) recursive least squares training to model the time-dynamic relationship between temperature, humidity, geographical coordinates, and cherry blossom dates. Public datasets, including meteorological data and historical bloom records, are processed to align with the temporal dynamics of ESN, ensuring structured input for prediction. FORCE training adapts the readout layer to non-linear, dynamic relation of the inputs and outputs. Compared to transformer-based models, reservoir computing requires significantly fewer learnable parameters while maintaining relatively accurate predictions, highlighting the potential of reservoir computing in real-world predictive challenges. With fixed internal weights and simplified training, ESNs are well-suited for neuromorphic hardware, offering a scalable and energy-efficient alternative to conventional forecasting methods. |

Adaptive Horizontal Pod Autoscaling (AHPA) based on Reinforcement Learning in Kubernetes for Machine LearningNatnicha Rodtong Tue, 11. 2. 2025, 1/367 and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz The field of artificial intelligence (AI) is rapidly expanding across various sectors, with many industries still in the early stages of adoption. Machine learning (ML) inference tasks, in particular, require substantial computational power, especially in terms of CPU and memory. Effective resource allocation for applications requires expertise to optimize system performance, throughput, and inference types, among other factors. Both under- and over-allocation can negatively impact application performance. Over-allocation can strain the scheduler, disrupt other active nodes, and lead to higher costs, reduced responsiveness, and decreased node capacity. Kubernetes, with its robust architecture, is a preferred choice for AI systems, as it efficiently handles AI workloads and dynamically scales applications based on data processing needs. This presents a valuable opportunity to leverage ML for assessing the computing resource requirements of such systems, with the goal of improving both service quality and resource efficiency. We thereby study, firstly, how can ML, especially reinforcement learning (RL), be utilized to predict future computing resource needs and dynamically adjust the number of Kubernetes Pods in a horizontal manner, enabling scaling in and out, to handle fluctuating demand of requests, secondly, what are the most suitable RL algorithms for implementing a Kubernetes horizontal autoscaler, and, finally, how does the reliability of an RL-based autoscaler for ML inference compare to a basic Kubernetes Horizontal Pod Autoscaler (HPA) in terms of average response time and packet loss. This study introduces the Adaptive Horizontal Pod Autoscaler (AHPA), which utilizes RL with a Deep Q-Network (DQN) to dynamically adjust the number of Kubernetes Pods for horizontal scaling, enabling both scaling in and scaling out. We evaluate the performance and reliability of AHPA in image classification tasks, comparing its effectiveness against a traditional horizontal autoscaler in Kubernetes. The results showed that RL, particularly the model-free, value-based approach using DQN, is an effective method for addressing the challenges of adaptive horizontal scaling in Kubernetes environments, efficiently accommodating the fluctuating volume of incoming requests for ML applications with impressive managing the dynamic nature of resource allocation. Furthermore, our proposed AHPA outperforms the standard Kubernetes HPA in terms of average latency, packet loss, and Pod utilization under most experimental conditions. However, under high-load conditions, Kubernetes HPA, which relies on fixed thresholds, outperformed AHPA. |

Contrastive learning - part 2René Larisch Thu, 30. 1. 2025, 1/346 and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz Deep neural networks have shown very good performance in object recognition and object detection tasks. To perform such a task, a good representation of different input features is necessary. It has been shown that representation learning methods, such as contrastive learning, provide good feature representation when used as a pretext task. In addition, recent contrastive learning methods are trained in an unsupervised manner, allowing the network to be trained on a large corpus of data without the need for labels. By providing a useful representation of input features, contrastive learning methods are also interesting as simple models of the visual cortex, providing input to higher cortical areas. In my talk, I will give a brief overview of the basic principles of contrastive learning, present different concepts for the further development, and discuss open problems in contrastive learning. |

Evolving Neuromorphic Micro-Architectures for Motor ControlMaximilian Titz Thu, 23. 1. 2025, 1/346 and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz Artificial intelligence (AI) research has predominantly focused on large-scale models like deep learning and large language models, which require significant computational resources. However, numerous AI applications exist that operate under strict constraints in terms of power consumption, memory, and form factor. Microrobotics represents one such application, in which these constraints are particularly amplified. This presents unique challenges for the architecture and algorithms used to control the robots. Spiking neural networks (RSNNs) implemented on specialized neuromorphic chips offer a higher power efficiency than conventional computing methods. Through emulating biological principles, such as in-memory computation, they enable bypassing the limits of conventional computing models. However, training RSNNs in resource-constrained environments remains a significant challenge. This thesis proposes a novel methodology that combines reservoir computing with evolutionary optimization techniques to minimize the memory overhead of training. The approach is evaluated on a reinforcement learning task using a software simulation of a neuromorphic chip and then extended by optimizing the input configurations to increase its effectiveness. The results highlight the potential of evolutionary optimization in training RSNNs for applications constrained by power and memory. |

Contrastive learning - part 1René Larisch Thu, 19. 12. 2024, 1/346 and https://webroom.hrz.tu-chemnitz.de/gl/jul-2tw-4nz Deep neural networks have shown very good performance in object recognition and object detection tasks. To perform such a task, a good representation of different input features is necessary. It has been shown that representation learning methods, such as contrastive learning, provide good feature representation when used as a pretext task. In addition, recent contrastive learning methods are trained in an unsupervised manner, allowing the network to be trained on a large corpus of data without the need for labels. By providing a useful representation of input features, contrastive learning methods are also interesting as simple models of the visual cortex, providing input to higher cortical areas. In my talk, I will give a brief overview of the basic principles of contrastive learning, present different concepts for the further development, and discuss open problems in contrastive learning. |